Интеллектуальные методы анализа данных вопросы теста. Методы интеллектуального анализа данных. Выявление и использование формализованных закономерностей

Введение

Сегодня мы являемся свидетелями активного развития технологии интеллектуального анализа данных (ИАД или data mining), появление которой связано, в первую очередь, с необходимостью аналитической обработки сверхбольших объемов информации, накапливаемой в современных хранилищах данных. Возможность использования хорошо известных методов математической статистики и машинного обучения для решения задач подобного рода открыло новые возможности перед аналитиками, исследователями, а также теми, кто принимает решения - менеджерами и руководителями компаний.

Сложность и разнообразие методов ИАД требуют создания специализированных средств конечного пользователя для решения типовых задач анализа информации в конкретных областях. Поскольку эти средства используются в составе сложных многофункциональных систем поддержки принятия решений, они должны легко интегрироваться в подобные системы. Одним из наиболее важных и перспективных направлений применения ИАД являются бизнес-приложения, поэтому опыт канадско-американской фирмы Cognos по реализации методов ИАД в составе интегрированных интеллектуальных систем поддержки принятия решений представляет интерес как для разработчиков, так и для пользователей.

Системы ИАД применяются в научных исследованиях и образовании, в работе правоохранительных органов, производстве, здравоохранении и многих других областях. Особенно широко технология ИАД используется в деловых приложениях.

В данной работе мы исследуем интеллектуальный анализ данных.

1. Интеллектуальный анализ данных

Интеллектуальный анализ данных (ИАД) обычно определяют как метод поддержки принятия решений, основанный на анализе зависимостей между данными. В рамках такой общей формулировки обычный анализ отчетов, построенных по базе данных, также может рассматриваться как разновидность ИАД. Чтобы перейти к рассмотрению более продвинутых технологий ИАД, посмотрим, как можно автоматизировать поиск зависимостей между данными.

Целью интеллектуального анализа данных (англ. Datamining, другие варианты перевода - "добыча данных", "раскопка данных") является обнаружение неявных закономерностей в наборах данных. Как научное направление он стал активно развиваться в 90-х годах XXвека, что было вызвано широким распространением технологий автоматизированной обработки информации и накоплением в компьютерных системах больших объемов данных . И хотя существующие технологии позволяли, например, быстро найти в базе данных нужную информацию, этого во многих случаях было уже недостаточно. Возникла потребность поиска взаимосвязей между отдельными событиями среди больших объемов данных, для чего понадобились методы математической статистики, теории баз данных, теории искусственного интеллекта и ряда других областей.

Классическим считается определение, данное одним из основателей направления Григорием Пятецким-Шапиро : DataMining - исследование и обнаружение "машиной" (алгоритмами, средствами искусственного интеллекта) в сырых данных скрытых знаний, которые ранее не были известны, нетривиальны, практически полезны, доступны для интерпретации.

Учитывая разнообразие форм представления данных, используемых алгоритмов и сфер применения, интеллектуальный анализ данных может проводиться с помощью программных продуктов следующих классов:

· специализированных "коробочных" программных продуктов для интеллектуального анализа;

· математических пакетов;

· электронных таблиц(и различного рода надстроек над ними);

· средств интегрированных в системы управления базами данных (СУБД);

· других программных продуктов.

В качестве примера можно привести СУБД MicrosoftSQLServer и входящие в ее состав службы AnalysisServices, обеспечивающие пользователей средствами аналитической обработки данных в режиме on-line (OLAP)и интеллектуального анализа данных, которые впервые появились в MSSQLServer 2000.

Не только Microsoft, но и другие ведущие разработчики СУБД имеют в своем арсенале средства интеллектуального анализа данных.

В ходе проведения интеллектуального анализа данных проводится исследование множества объектов (или вариантов). В большинстве случаев его можно представить в виде таблицы, каждая строка которой соответствует одному из вариантов, а в столбцах содержатся значения параметров, его характеризующих. Зависимая переменная - параметр, значение которого рассматриваем как зависящее от других параметров (независимых переменных). Собственно эту зависимость и необходимо определить, используя методы интеллектуального анализа данных.

Рассмотрим основные задачи интеллектуального анализа данных.

Задача классификации заключается в том, что для каждого варианта определяется категория или класс, которому он принадлежит. В качестве примера можно привести оценку кредитоспособности потенциального заемщика: назначаемые классы здесь могут быть "кредитоспособен" и "некредитоспособен". Необходимо отметить, что для решения задачи необходимо, чтобы множество классов было известно заранее и было бы конечным и счетным.

Задача регрессии во многом схожа с задачей классификации, но в ходе ее решения производится поиск шаблонов для определения числового значения. Иными словами, предсказываемый параметр здесь, как правило, число из непрерывного диапазона.

Отдельно выделяется задача прогнозирования новых значений на основании имеющихся значений числовой последовательности (или нескольких последовательностей, между значениями в которых наблюдается корреляция). При этом могут учитываться имеющиеся тенденции (тренды), сезонность, другие факторы. Классическим примером является прогнозирование цен акций на бирже.

Тут требуется сделать небольшое отступление. По способу решения задачи интеллектуального анализа можно разделить на два класса: обучение с учителем (от англ. supervisedlearning) и обучение без учителя (от англ. unsupervisedlearning). В первом случае требуется обучающий набор данных, на котором создается и обучается модель интеллектуального анализа данных. Готовая модель тестируется и впоследствии используется для предсказания значений в новых наборах данных. Иногда в этом же случае говорят об управляемых алгоритмах интеллектуального анализа. Задачи классификации и регрессии относятся как раз к этому типу.

Во втором случае целью является выявление закономерностей имеющихся в существующем наборе данных. При этом обучающая выборка не требуется. В качестве примера можно привести задачу анализа потребительской корзины, когда в ходе исследования выявляются товары, чаще всего покупаемые вместе. К этому же классу относится задача кластеризации.

Также можно говорить о классификации задач интеллектуального анализа данных по назначению, в соответствии с которой, они делятся на описательные (descriptive) и предсказательные (predictive). Цель решения описательных задач - лучше понять исследуемые данные, выявить имеющиеся в них закономерности, даже если в других наборах данных они встречаться не будут. Для предсказательных задач характерно то, что в ходе их решения на основании набора данных с известными результатами строится модель для предсказания новых значений.

Но вернемся к перечислению задач интеллектуального анализа данных.

Задача кластеризации - заключается в делении множества объектов на группы (кластеры) схожих по параметрам. При этом, в отличие от классификации, число кластеров и их характеристики могут быть заранее неизвестны и определяться в ходе построения кластеров исходя из степени близости объединяемых объектов по совокупности параметров.

Другое название этой задачи - сегментация. Например, интернет-магазин может быть заинтересован в проведении подобного анализа базы своих клиентов, для того, чтобы потом сформировать специальные предложения для выделенных групп, учитывая их особенности.

Кластеризация относится к задачам обучения без учителя (или "неуправляемым" задачам).

Задача определения взаимосвязей , также называемая задачей поиска ассоциативных правил , заключается в определении часто встречающихся наборов объектов среди множества подобных наборов. Классическим примером является анализ потребительской корзины, который позволяет определить наборы товаров, чаще всего встречающиеся в одном заказе (или в одном чеке). Эта информация может потом использоваться при размещении товаров в торговом зале или при формировании специальных предложений для группы связанных товаров.

Данная задача также относится к классу "обучение без учителя".

Анализ последовательностей или сиквенциальный анализ одними авторами рассматривается как вариант предыдущей задачи, другими - выделяется отдельно. Целью, в данном случае, является обнаружение закономерностей в последовательностях событий. Подобная информация позволяет, например, предупредить сбой в работе информационной системы, получив сигнал о наступлении события, часто предшествующего сбою подобного типа. Другой пример применения - анализ последовательности переходов по страницам пользователей web-сайтов.

Анализ отклонений позволяет отыскать среди множества событий те, которые существенно отличаются от нормы. Отклонение может сигнализировать о каком-то необычном событии (неожиданный результат эксперимента, мошенническая операция по банковской карте …) или, например, об ошибке ввода данных оператором.

В таблице 1.1 приведены примеры задач интеллектуального анализа данных из различных областей.

|

Таблица 1.1. Примеры применения интеллектуального анализа данных |

||

|

Информационные технологии |

Торговля |

Финансовая сфера |

|

Классификация |

Оценка кредитоспособности |

|

|

Регрессия |

Оценка допустимого кредитного лимита |

|

|

Прогнозирование |

Прогнозирование продаж |

Прогнозирование цен акции |

|

Кластеризации |

Сегментация клиентов |

Сегментация клиентов |

|

Определения взаимосвязей |

Анализ потребительской корзины |

|

|

Анализ последовательностей |

Анализ переходов по страницам web-сайта |

|

|

Анализ отклонений |

Обнаружение вторжений в информационные системы |

Выявление мошенничества с банковскими картами |

Сегодня количество фирм, предлагающих продукты ИАД, исчисляется десятками, однако, не рассматривая их подробно, приведем лишь классификацию процессов ИАД, применяющихся на практике.

В системах ИАД применяется чрезвычайно широкий спектр математических, логических и статистических методов: от анализа деревьев решений (Business Objects) до нейронных сетей (NeoVista). Пока трудно говорить о перспективности или предпочтительности тех или иных методов. Технология ИАД сейчас находится в начале пути, и практического материала для каких-либо рекомендаций или обобщений явно недостаточно.

Необходимо также упомянуть об интеграции ИАД в информационные системы. Многие методы ИАД возникли из задач экспертного анализа, поэтому входными данными для них традиционно служат "плоские" файлы данных. При использовании ИАД в СППР часто приходится сначала извлекать данные из Хранилища, преобразовывать их в файлы нужных форматов и только потом переходить собственно к интеллектуальному анализу. Затем результаты анализа требуется сформулировать в терминах бизнес-понятий. Важный шаг вперед сделала компания Information Discovery, разработавшая системы OLAP Discovery System и OLAP Affinity System, предназначенные специально для интеллектуального анализа многомерных агрегированных данных .

интеллектуальный анализ данные прогнозирование

Заключение

Интеллектуальный анализ данных (ИАД, data mining, KDD - knowledge discovery in databases) представляет собой новейшее направление в области информационных систем (ИС), ориентированное на решение задач поддержки принятия решений на основе количественных и качественных исследований сверхбольших массивов разнородных ретроспективных данных.

Интеллектуальный анализ данных является одним из наиболее актуальных и востребованных направлений прикладной математики. Современные процессы бизнеса и производства порождают огромные массивы данных, и людям становится все труднее интерпретировать и реагировать на большое количество данных, которые динамически изменяются во времени выполнения, не говоря уже о предупреждении критических ситуаций. «Интеллектуальный анализ данных» извлечь максимум полезных знаний из многомерных, разнородных, неполных, неточных, противоречивых, косвенных данных. Помогает сделать это эффективно, если объем данных измеряется гигабайтами или даже терабайтами. Помогает строить алгоритмы, способные обучаться принятию решений в различных профессиональных областях.

Средства «Интеллектуального анализа данных» предохраняют людей от информационной перегрузки, перерабатывая оперативные данные в полезную информацию так, чтобы нужные действия могли быть приняты в нужные времена.

Прикладные разработки ведутся по следующим направлениям: прогнозирование в экономических системах; автоматизация маркетинговых исследований и анализ клиентских сред для производственных, торговых, телекоммуникационных и Интернет-компаний; автоматизация принятия кредитных решений и оценка кредитных рисков; мониторинг финансовых рынков; автоматические торговые системы.

Список литературы

1. Тельнов Ю.Ф. Интеллектуальные информационные системы в экономике. М. СИНТЕГ 2002. 306 с.

2. Дюк В., Самойленко А. Data Mining. Издательский дом "Питер". СПб, 2001.

3. Васильев В.П. Информационно-аналитические системы. Практикум на ПК.МФ МЭСИ -2007.

Использование данных является проблемой при составлении программ и разработке информационных систем. Прежде чем выполнить анализ большого объема данных и принять решение, гарантирующее достоверный и объективный результат, необходимо определить этот большой объем. Задача усложняется, если поток информации стремительно растет, а время на принятие решения ограничено.

Данные и их формализация

Современные информационные технологии гарантируют безопасный и надежный анализ, представление и обработку данных. Синтаксически и формально это верно. С точки зрения семантики задачи и объективности ожидаемого решения - результат зависит от опыта, знаний и умений программиста.

Языки программирования находятся в статусе надежного и безопасного инструмента. Знания и умения специалистов анализировать, представлять и обрабатывать данные пришли к уровню относительной универсальности.

Технологии интеллектуального анализа данных на этом уровне практически безупречны. Тип данных может быть известен к моменту операции над ними, а в случае несоответствия - будет автоматически приведен к нужному типу.

Развиты инструменты гипертекста, повсеместно используется распределенная обработка больших объемов данных. На этом уровне:

- информационные задачи поддаются формализации;

- потребности к интеллектуальному анализу удовлетворяются;

- качество результата зависит от качества знаний и профессионализма программиста.

Ситуация в программировании информационных систем уровня предприятия характеризуется наличием реально работающих продуктов, обеспечивающих формирование больших объемов данных и проблему более высокого порядка.

Большие объемы данных

В 80-е годы, когда базы данных становились системами управления базами данных, повышение надежности аппаратного обеспечения и качество языков программирования оставляли желать лучшего.

В настоящее время накопилось большое количество баз данных, многие источники информации компьютеризированы, разработаны сложные системы сбора различной информации (финансы, погода, статистика, налоги, недвижимость, персональные данные, климат, политика...).

Некоторые источники данных характеризуются очевидными закономерностями и поддаются анализу математическими методами. Можно выполнить интеллектуальный анализ данных в Excel: очистить данные, построить модель, сформировать гипотезу, определить корреляции и т.д.

В некоторых данных и источниках закономерности трудно обнаружить. Во всех случаях программно-аппаратное обеспечение для обработки данных характеризуется надежностью и стабильностью. Задача интеллектуального анализа данных стала во главе угла во многих социально-экономических сферах.

Лидеры информационной отрасли, в частности Oracle, фокусируют свое внимание на спектре обстоятельств, характеризующих данные нового типа:

- огромные потоки;

- естественная информация (даже если она создана программно);

- разнородные данные;

- высочайшие критерии ответственности;

- широкий спектр форматов представления данных;

- совместимость интеграторов данных и их обработчиков.

Главная особенность данных нового типа: огромный объем и скорость нарастания этого объема. Классические алгоритмы не применимы для обработки данных нового типа даже с учетом быстродействия современных компьютеров и применения параллельных технологий.

От бэкапа к миграции и интеграции

Раньше была актуальна задача безопасного хранения информации (бэкап, резервное копирование). Сегодня актуальна проблема миграции множественных представлений данных (разные форматы и кодировки) и их интеграции в единое целое.

Без технологии интеллектуального анализа данных многие задачи не решить. Здесь не идет речь о принятии решений, определении зависимостей, создании алгоритмов данных для последующей обработки. Слияние разнородных данных стало проблемой, и привести источники информации к единому формализованному основанию нет возможности.

Интеллектуальный анализ данных большого объема требует определения этого объема и создания технологии (алгоритма, эвристик, наборов правил) для получения возможности поставить задачу и решить ее.

Data mining: что копать

Понятие анализа данных в контексте интеллектуальных методов начало активно развиваться с начала 90-х годов прошлого века. Искусственный интеллект к этому времени не оправдал надежд, но необходимость в принятии обоснованных решений на основе анализа информации стала стремительно расти.

Машинное обучение, интеллектуальный анализ данных, распознавание образов, визуализация, теория баз данных, алгоритмизация, статистика, математические методы составили спектр задач новой, активно развивающейся область знаний, которую ассоциируют с англоязычным data minig.

На практике новая область знаний приобрела междисциплинарный характер и находится в стадии становления. Благодаря опыту и программной продукции от Oracle, Microsoft, IBM и других лидирующих компаний сложилось отчетливое представление о том, что такое интеллектуальный анализ данных, но вопросов еще очень много. Достаточно сказать, что линейка программных изделий от Oracle, посвященная исключительно большим объемам информации, их интеграции, совместимости, миграции и обработке - это более сорока позиций!

Что нужно, чтобы поставить задачу обработки больших данных правильно и получить обоснованное решение? Ученые и практики сходятся на обобщенном понимании фразы «поиск скрытых закономерностей». Здесь сочетаются три позиции:

- неочевидность;

- объективность;

- практическая полезность.

Первая позиция означает, что обычными методами не определить, что нужно найти и как это сделать. Классическое программирование здесь не применимо. Нужен если не искусственный интеллект, то хотя бы программы для интеллектуального анализа данных. Термин «интеллектуального» представляет собой не меньшую проблему, чем задача определения достаточного объема данных для принятия начальных решений и формулировки исходных правил работы.

Объективность - своего рода гарантия, что выбранная технология, разработанная «интеллектуальная» методика или спектр «интеллектуальных» правил дадут основание считать полученные результаты правильными не только автору, но и любому другому специалисту.

Oracle в своих программных изделиях добавляет к понятию объективность статус безопасного, лишенного постороннего негативного вмешательства.

Практическая полезность - самый важный критерий для результата и алгоритма решения задачи интеллектуального анализа данных в конкретном применении.

Data mining: где копать

Бизнес-интеллект (Business Intelligence - BI) - основа современного, самого дорогого и востребованного программного обеспечения. Поставщики бизнес-решений считают, что нашли способ решения задач по обработке больших объемов данных, и их программные изделия могут обеспечить безопасное и стремительное развитие бизнеса компании любого размера.

Как в случае искусственного интеллекта в области средства интеллектуального анализа данных, не следует слишком сильно преувеличивать текущие достижения. Все только становится на ноги, но и отрицать реальные результаты тоже нельзя.

Вопрос сферы применения. Разработаны алгоритмы интеллектуального анализа данных в экономике, на производстве, в области информации о климате, о курсах на валютной бирже. Существуют интеллектуальные продукты по защите предприятия от негативного влияния уволенных сотрудников (область психологии и социологии - сильная тема), от вирусных атак.

Многие разработки реально выполняют функции, декларируемые их изготовителями. Фактически задача - что делать и где это делать - приобрела осмысленный и объективный контекст:

- минимально возможная область применения;

- максимально точная и четкая цель;

- источники данных и данные, приведенные к одному основанию.

Только область применения и ожидаемая практическая полезность могут помочь сформулировать технологии, методики, правила и основы интеллектуального анализа данных в конкретной сфере, ради конкретной цели.

Информационные технологии сделали заявку на научную дисциплину, и не следует гнушаться небольшими шагами в новом, неизведанном направлении. Позарившись на святая святых - естественный интеллект, человек не может требовать от себя того, что сделать не в состоянии.

Решить, что делать и где это делать, на сегодняшний день крайне трудно. На конкретном бизнесе, в конкретной области человеческой деятельности можно очертить объем информации, подлежащей исследованию, и получить решение, которое будет характеризоваться какой-то долей достоверности и показателем объективности.

Data mining: как копать

Профессиональное программирование и собственный высококвалифицированный персонал - единственный инструмент для достижения желаемого.

Пример 1. Задача интеллектуального анализа данных не будет решена чистым применением Oracle Controller. Этот продукт заявлен как полнофункциональный и расширяемый инструмент тестирования нагрузки. Это крайне узкая задача. Только нагрузка! Ничего более, никаких высокоинтеллектуальных задач.

Однако задачи, на которых применяется данный продукт, могут поставить в тупик не только тестировщика, но и разработчика, при всех его регалиях лидера отрасли. В частности, тестирование - это требование функциональной полноты. Где гарантия, что Oracle Controller «в курсе», какие наборы данных могут поступать на вход тестируемого приложения, сервера, программно-аппаратного комплекса.

Пример 2. Oracle Business Intelligence Suite Foundation Edition for Oracle Applications - разработчик декларирует этот продукт как удачное сочетание используемого ПО с экспертными знаниями построения, развития и обеспечения крупного бизнеса.

Бесспорно, опыт Oracle велик, но этого не достаточно для его трансформации через программно-экспертное изделие. На конкретном предприятии, в конкретном регионе Business Intelligence от Oracle может не сработать от решения налоговой службы или постановления местного муниципалитета.

Разумное применение современных технологий

Единственное правильное решение в области больших объемов информации, data mining и системы интеллектуального анализа данных в компании, государственном учреждении и в любой социально-экономической сфере - коллектив специалистов.

Знания и опыт квалифицированных специалистов - это единственно правильное решение, которое даст комплексный ответ на вопрос:

- data mining: что копать, где это делать и как?

Приобрести приоритетные продукты соответствующего назначения лишним не будет, но прежде чем это делать, потребуется изучить область применения, сформулировать ориентировочное решение и поставить предварительную цель.

Только после того, как предметная область определена и цель примерно ясна, можно заняться поиском уже разработанных и проверенных практикой решений. Скорее всего, будет найден продукт, который позволит уточнить предметную область и цель.

Никакая программа сегодня не справится с реальной задачей. Проиграв в области искусственного интеллекта в начале 80-х годов прошлого века, человек-разумный еще не может рассчитывать, что способен написать программу, решающую интеллектуальные задачи.

Не следует надеяться, что ИИ придет сам, а купленная у Oracle, Microsoft или IBM программа скажет, что нужно было делать, как и какой результат считать правильным. В современном мире информационных технологий идет бурный прогресс. В нем можно принять эффективное участие, усилить позиции своего бизнеса или решить задачу, которую трудно было поставить. Но нужно принимать участие, а не рассчитывать на программу.

Программирование - это статический труд, его результат - жесткий алгоритм. Современное интеллектуальное правило или эвристика - это жестко поставленное решение, которое не сработает при первой попавшейся оказии.

Моделирование и тестирование

Интеллектуальный анализ больших данных - действительно востребованная и актуальная задача. Но область применения до обнаружения этой задачи худо-бедно, но жила и развивалась.

Необходимость в дальнейшем развитии бизнеса ставит новые задачи, которые позволяют концептуально очертить объемы подлежащих обработке больших данных. Это естественный процесс научно-технического и интеллектуального развития предприятия, компании, бизнеса. Это же можно отнести к интернет-технологиям, к задачам парсинга информации на просторах интернета.

Существует множество новых задач и приложений, которые востребованы, могут быть более-менее четко поставлены и характеризуются объективным параметром: в их решении есть востребованный интерес и есть понимание вероятной полезности.

Моделирование - достаточно разработанная область, которая оснащена множеством проверенных математических методов. Модель можно построить всегда, было бы время и желание.

Моделирование позволяет сфокусировать все имеющиеся знания в одну систему и совершенствовать ее на наборе тестовых данных циклически. Это классический путь развития, который также прошел проверку практикой.

Если не строить воздушных замков, а со стабильной уверенностью идти к поставленной цели, то можно определить и путь, и желаемое решение, и конечную цель.

Именно программирование в начале 80-х годов прошлого века подтолкнуло общественное сознание к рождению идей искусственного интеллекта, именно оно стало родоначальником data mining, и именно с него начались методы интеллектуального анализа данных.

В те далекие времена проблемы больших объемов данных не существовало. Сегодня есть не только большие объемы данных, но и результат развития систем управления базами данных - значительный опыт в реляционных отношениях, как основе основ для представления данных.

Реляционные отношения - это часть, но не целое. Есть еще понятие системности, иерархии и много того, чем владеет интеллект естественный, но не может реализовать интеллекте искусственный: в данном случае - в программировании.

Программирование не есть интеллект ни в каком смысле, но это реальный результат применения интеллекта на практике. В этом его смысл, и именно это можно использовать в достижении желаемых целей.

Активные знания и умения

Любая программа - это статика. Она представляет собой конструирование в рамках синтаксиса языка программирования.

Современные языки программирования - совершенный результат 80-х годов, и это отрицать никак нельзя. Нельзя также не заметить, что современные языки программирования дают возможность создавать свободные алгоритмы за пределами своего синтаксиса.

Если кто-либо когда-либо сможет написать программу, которая будет работать не по воле ее автора, а по воле приобретенных ею знаний и умений, проблема больших объемов данных и принятия интеллектуальных решений будет закрыта, и начнется новый виток развития знаний.

Отправить свою хорошую работу в базу знаний просто. Используйте форму, расположенную ниже

Студенты, аспиранты, молодые ученые, использующие базу знаний в своей учебе и работе, будут вам очень благодарны.

Подобные документы

Перспективные направления анализа данных: анализ текстовой информации, интеллектуальный анализ данных. Анализ структурированной информации, хранящейся в базах данных. Процесс анализа текстовых документов. Особенности предварительной обработки данных.

реферат , добавлен 13.02.2014

Рождение искусственного интеллекта. История развития нейронных сетей, эволюционного программирования, нечеткой логики. Генетические алгоритмы, их применение. Искусственный интеллект, нейронные сети, эволюционное программирование и нечеткая логика сейчас.

реферат , добавлен 22.01.2015

Совершенствование технологий записи и хранения данных. Специфика современных требований к переработке информационных данных. Концепция шаблонов, отражающих фрагменты многоаспектных взаимоотношений в данных в основе современной технологии Data Mining.

контрольная работа , добавлен 02.09.2010

Описание функциональных возможностей технологии Data Mining как процессов обнаружения неизвестных данных. Изучение систем вывода ассоциативных правил и механизмов нейросетевых алгоритмов. Описание алгоритмов кластеризации и сфер применения Data Mining.

контрольная работа , добавлен 14.06.2013

Основы для проведения кластеризации. Использование Data Mining как способа "обнаружения знаний в базах данных". Выбор алгоритмов кластеризации. Получение данных из хранилища базы данных дистанционного практикума. Кластеризация студентов и задач.

курсовая работа , добавлен 10.07.2017

Классификация задач Data Mining. Задача кластеризации и поиска ассоциативных правил. Определению класса объекта по его свойствам и характеристикам. Нахождение частых зависимостей между объектами или событиями. Оперативно-аналитическая обработка данных.

контрольная работа , добавлен 13.01.2013

Создание структуры интеллектуального анализа данных. Дерево решений. Характеристики кластера, определение групп объектов или событий. Линейная и логистическая регрессии. Правила ассоциативных решений. Алгоритм Байеса. Анализ с помощью нейронной сети.

контрольная работа , добавлен 13.06.2014

По сути, интеллектуальный анализ данных - это обработка информации и выявление в ней моделей и тенденций, которые помогают принимать решения. Принципы интеллектуального анализа данных известны в течение многих лет, но с появлением больших данных они получили еще более широкое распространение.

Большие данные привели к взрывному росту популярности более широких методов интеллектуального анализа данных, отчасти потому, что информации стало гораздо больше, и она по самой своей природе и содержанию становится более разнообразной и обширной. При работе с большими наборами данных уже недостаточно относительно простой и прямолинейной статистики. Имея 30 или 40 миллионов подробных записей о покупках, недостаточно знать, что два миллиона из них сделаны в одном и том же месте. Чтобы лучше удовлетворить потребности покупателей, необходимо понять, принадлежат ли эти два миллиона к определенной возрастной группе, и знать их средний заработок.

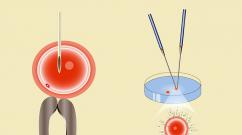

Эти бизнес-требования привели от простого поиска и статистического анализа данных к более сложному интеллектуальному анализу данных. Для решения бизнес-задач требуется такой анализ данных, который позволяет построить модель для описания информации и в конечном итоге приводит к созданию результирующего отчета. Этот процесс иллюстрирует .

Рисунок 1. Схема процесса

Процесс анализа данных, поиска и построения модели часто является итеративным, так как нужно разыскать и выявить различные сведения, которые можно извлечь. Необходимо также понимать, как связать, преобразовать и объединить их с другими данными для получения результата. После обнаружения новых элементов и аспектов данных подход к выявлению источников и форматов данных с последующим сопоставлением этой информации с заданным результатом может измениться.

Инструменты интеллектуального анализа данных

Интеллектуальный анализ данных ― это не только используемые инструменты или программное обеспечение баз данных. Интеллектуальный анализ данных можно выполнить с относительно скромными системами баз данных и простыми инструментами, включая создание своих собственных, или с использованием готовых пакетов программного обеспечения. Сложный интеллектуальный анализ данных опирается на прошлый опыт и алгоритмы, определенные с помощью существующего программного обеспечения и пакетов, причем с различными методами ассоциируются разные специализированные инструменты.

Например, IBM SPSS®, который уходит корнями в статистический анализ и опросы, позволяет строить эффективные прогностические модели по прошлым тенденциям и давать точные прогнозы. IBM InfoSphere® Warehouse обеспечивает в одном пакете поиск источников данных, предварительную обработку и интеллектуальный анализ, позволяя извлекать информацию из исходной базы прямо в итоговый отчет.

В последнее время стала возможна работа с очень большими наборами данных и кластерная/крупномасштабная обработка данных, что позволяет делать еще более сложные обобщения результатов интеллектуального анализа данных по группам и сопоставлениям данных. Сегодня доступен совершенно новый спектр инструментов и систем, включая комбинированные системы хранения и обработки данных.

Можно анализировать самые разные наборы данных, включая традиционные базы данных SQL, необработанные текстовые данные, наборы "ключ/значение" и документальные базы. Кластерные базы данных, такие как Hadoop, Cassandra, CouchDB и Couchbase Server, хранят и предоставляют доступ к данным такими способами, которые не соответствуют традиционной табличной структуре.

В частности, более гибкий формат хранения базы документов придает обработке информации новую направленность и усложняет ее. Базы данных SQL строго регламентируют структуру и жестко придерживаются схемы, что упрощает запросы к ним и анализ данных с известными форматом и структурой.

Документальные базы данных, которые соответствуют стандартной структуре типа JSON, или файлы с некоторой машиночитаемой структурой тоже легко обрабатывать, хотя дело может осложняться разнообразной и переменчивой структурой. Например, в Hadoop, который обрабатывает совершенно "сырые" данные, может быть трудно выявить и извлечь информацию до начала ее обработки и сопоставления.

Основные методы

Несколько основных методов, которые используются для интеллектуального анализа данных, описывают тип анализа и операцию по восстановлению данных. К сожалению, разные компании и решения не всегда используют одни и те же термины, что может усугубить путаницу и кажущуюся сложность.

Рассмотрим некоторые ключевые методы и примеры того, как использовать те или иные инструменты для интеллектуального анализа данных.

Ассоциация

Ассоциация (или отношение), вероятно, наиболее известный, знакомый и простой метод интеллектуального анализа данных. Для выявления моделей делается простое сопоставление двух или более элементов, часто одного и того же типа. Например, отслеживая привычки покупки, можно заметить, что вместе с клубникой обычно покупают сливки.

Создать инструменты интеллектуального анализа данных на базе ассоциаций или отношений нетрудно. Например, в InfoSphere Warehouse есть мастер, который выдает конфигурации информационных потоков для создания ассоциаций, исследуя источник входной информации, базис принятия решений и выходную информацию. приведен соответствующий пример для образца базы данных.

Рисунок 2. Информационный поток, используемый при подходе ассоциации

Классификация

Классификацию можно использовать для получения представления о типе покупателей, товаров или объектов, описывая несколько атрибутов для идентификации определенного класса. Например, автомобили легко классифицировать по типу (седан, внедорожник, кабриолет), определив различные атрибуты (количество мест, форма кузова, ведущие колеса). Изучая новый автомобиль, можно отнести его к определенному классу, сравнивая атрибуты с известным определением. Те же принципы можно применить и к покупателям, например, классифицируя их по возрасту и социальной группе.

Кроме того, классификацию можно использовать в качестве входных данных для других методов. Например, для определения классификации можно применять деревья принятия решений. Кластеризация позволяет использовать общие атрибуты различных классификаций в целях выявления кластеров.

Исследуя один или более атрибутов или классов, можно сгруппировать отдельные элементы данных вместе, получая структурированное заключение. На простом уровне при кластеризации используется один или несколько атрибутов в качестве основы для определения кластера сходных результатов. Кластеризация полезна при определении различной информации, потому что она коррелируется с другими примерами, так что можно увидеть, где подобия и диапазоны согласуются между собой.

Метод кластеризации работает в обе стороны. Можно предположить, что в определенной точке имеется кластер, а затем использовать свои критерии идентификации, чтобы проверить это. График, изображенный на , демонстрирует наглядный пример. Здесь возраст покупателя сравнивается со стоимостью покупки. Разумно ожидать, что люди в возрасте от двадцати до тридцати лет (до вступления в брак и появления детей), а также в 50-60 лет (когда дети покинули дом) имеют более высокий располагаемый доход.

Рисунок 3. Кластеризация

В этом примере видны два кластера, один в районе $2000/20-30 лет и другой в районе $7000-8000/50-65 лет. В данном случае мы выдвинули гипотезу и проверили ее на простом графике, который можно построить с помощью любого подходящего ПО для построения графиков. Для более сложных комбинаций требуется полный аналитический пакет, особенно если нужно автоматически основывать решения на информации о ближайшем соседе .

Такое построение кластеров являет собой упрощенный пример так называемого образа ближайшего соседа . Отдельных покупателей можно различать по их буквальной близости друг к другу на графике. Весьма вероятно, что покупатели из одного и того же кластера разделяют и другие общие атрибуты, и это предположение можно использовать для поиска, классификации и других видов анализа членов набора данных.

Метод кластеризации можно применить и в обратную сторону: учитывая определенные входные атрибуты, выявлять различные артефакты. Например, недавнее исследование четырехзначных PIN-кодов выявили кластеры чисел в диапазонах 1-12 и 1-31 для первой и второй пар. Изобразив эти пары на графике, можно увидеть кластеры, связанные с датами (дни рождения, юбилеи).

Прогнозирование

Прогнозирование ― это широкая тема, которая простирается от предсказания отказов компонентов оборудования до выявления мошенничества и даже прогнозирования прибыли компании. В сочетании с другими методами интеллектуального анализа данных прогнозирование предполагает анализ тенденций, классификацию, сопоставление с моделью и отношения. Анализируя прошлые события или экземпляры, можно предсказывать будущее.

Например, используя данные по авторизации кредитных карт, можно объединить анализ дерева решений прошлых транзакций человека с классификацией и сопоставлением с историческими моделями в целях выявления мошеннических транзакций. Если покупка авиабилетов в США совпадает с транзакциями в США, то вполне вероятно, что эти транзакции подлинны.

Последовательные модели

Последовательные модели, которые часто используются для анализа долгосрочных данных, ― полезный метод выявления тенденций, или регулярных повторений подобных событий. Например, по данным о покупателях можно определить, что в разное время года они покупают определенные наборы продуктов. По этой информации приложение прогнозирования покупательской корзины, основываясь на частоте и истории покупок, может автоматически предположить, что в корзину будут добавлены те или иные продукты.

Деревья решений

Дерево решений, связанное с большинством других методов (главным образом, классификации и прогнозирования), можно использовать либо в рамках критериев отбора, либо для поддержки выбора определенных данных в рамках общей структуры. Дерево решений начинают с простого вопроса, который имеет два ответа (иногда больше). Каждый ответ приводит к следующему вопросу, помогая классифицировать и идентифицировать данные или делать прогнозы.

Рисунок 5. Подготовка данных

Источник данных, местоположение и база данных влияют на то, как будет обрабатываться и объединяться информация.

Опора на SQL

Наиболее простым из всех подходов часто служит опора на базы данных SQL. SQL (и соответствующая структура таблицы) хорошо понятен, но структуру и формат информации нельзя игнорировать полностью. Например, при изучении поведения пользователей по данным о продажах в модели данных SQL (и интеллектуального анализа данных в целом) существуют два основных формата, которые можно использовать: транзакционный и поведенческо-демографический.

При работе с InfoSphere Warehouse создание поведенческо-демографической модели в целях анализа данных о покупателях для понимания моделей их поведения предусматривает использование исходных данных SQL, основанных на информации о транзакциях, и известных параметров покупателей с организацией этой информации в заранее определенную табличную структуру. Затем InfoSphere Warehouse может использовать эту информацию для интеллектуального анализа данных методом кластеризации и классификации с целью получения нужного результата. Демографические данные о покупателях и данные о транзакциях можно скомбинировать, а затем преобразовать в формат, который допускает анализ определенных данных, как показано на .

Рисунок 6. Специальный формат анализа данных

Например, по данным о продажах можно выявить тенденции продаж конкретных товаров. Исходные данные о продажах отдельных товаров можно преобразовать в информацию о транзакциях, в которой идентификаторы покупателей сопоставляются с данными транзакций и кодами товаров. Используя эту информацию, легко выявить последовательности и отношения для отдельных товаров и отдельных покупателей с течением времени. Это позволяет InfoSphere Warehouse вычислять последовательную информацию, определяя, например, когда покупатель, скорее всего, снова приобретет тот же товар.

Из исходных данных можно создавать новые точки анализа данных. Например, можно развернуть (или доработать) информацию о товаре путем сопоставления или классификации отдельных товаров в более широких группах, а затем проанализировать данные для этих групп, вместо отдельных покупателей.

Рисунок 7. Структура MapReduce

В предыдущем примере мы выполнили обработку (в данном случае посредством MapReduce) исходных данных в документальной базе данных и преобразовали ее в табличный формат в базе данных SQL для целей интеллектуального анализа данных.

Для работы с этой сложной и даже неструктурированной информацией может потребоваться более тщательная подготовка и обработка. Существуют сложные типы и структуры данных, которые нельзя обработать и подготовить в нужном вам виде за один шаг. В этом случае можно направить выход MapReduce либо для последовательного преобразования и получения необходимой структуры данных, как показано на , либо для индивидуального изготовления нескольких таблиц выходных данных.

Рисунок 8. Последовательная цепочка вывода результатов обработки MapReduce

Например, за один проход можно взять исходную информацию из документальной базы данных и выполнить операцию MapReduce для получения краткого обзора этой информации по датам. Хорошим примером последовательного процесса является регенеририрование информации и комбинирование результатов с матрицей решений (создается на втором этапе обработки MapReduce) с последующим дополнительным упрощением в последовательную структуру. На этапе обработки MapReduce требуется, чтобы весь набор данных поддерживал отдельные шаги обработки данных.

Независимо от исходных данных, многие инструменты могут использовать неструктурированные файлы, CSV или другие источники данных. Например, InfoSphere Warehouse в дополнение к прямой связи с хранилищем данных DB2 может анализировать неструктурированные файлы.

Заключение

Интеллектуальный анализ данных - это не только выполнение некоторых сложных запросов к данным, хранящимся в базе данных. Независимо от того, используете ли вы SQL, базы данных на основе документов, такие как Hadoop, или простые неструктурированные файлы, необходимо работать с данными, форматировать или реструктурировать их. Требуется определить формат информации, на котором будет основываться ваш метод и анализ. Затем, когда информация находится в нужном формате, можно применять различные методы (по отдельности или в совокупности), не зависящие от требуемой базовой структуры данных или набора данных.

Целью интеллектуального анализа данных (англ. Datamining, другие варианты перевода - "добыча данных", "раскопка данных") является обнаружение неявных закономерностей в наборах данных. Как научное направление он стал активно развиваться в 90-х годах XXвека, что было вызвано широким распространением технологий автоматизированной обработки информации и накоплением в компьютерных системах больших объемов данных [ , ]. И хотя существующие технологии позволяли, например, быстро найти в базе данных нужную информацию, этого во многих случаях было уже недостаточно. Возникла потребность поиска взаимосвязей между отдельными событиями среди больших объемов данных, для чего понадобились методы математической статистики, теории баз данных, теории искусственного интеллекта и ряда других областей.

Классическим считается определение ,данное одним из основателей направления Григорием Пятецким-Шапиро : DataMining - исследование и обнаружение "машиной" (алгоритмами, средствами искусственного интеллекта) в сырых данных скрытых знаний, которые ранее не были известны, нетривиальны, практически полезны, доступны для интерпретации.

Учитывая разнообразие форм представления данных, используемых алгоритмов и сфер применения, интеллектуальный анализ данных может проводиться с помощью программных продуктов следующих классов:

- специализированных "коробочных" программных продуктов для интеллектуального анализа;

- математических пакетов;

- электронных таблиц(и различного рода надстроек над ними);

- средств интегрированных в системы управления базами данных (СУБД);

- других программных продуктов.

В рамках данного курса нас в первую очередь будут интересовать средства, интегрированные с СУБД . В качестве примера можно привести СУБД MicrosoftSQLServer и входящие в ее состав службы AnalysisServices, обеспечивающие пользователей средствами аналитической обработки данных в режиме on-line ( OLAP )и интеллектуального анализа данных, которые впервые появились в MSSQLServer 2000.

Не только Microsoft, но и другие ведущие разработчики СУБД имеют в своем арсенале средства интеллектуального анализа данных.

Задачи интеллектуального анализа данных

В ходе проведения интеллектуального анализа данных проводится исследование множества объектов (или вариантов). В большинстве случаев его можно представить в виде таблицы, каждая строка которой соответствует одному из вариантов, а в столбцах содержатся значения параметров, его характеризующих. Зависимая переменная - параметр , значение которого рассматриваем как зависящее от других параметров (независимых переменных). Собственно эту зависимость и необходимо определить, используя методы интеллектуального анализа данных.

Рассмотрим основные задачи интеллектуального анализа данных.

Задача классификации заключается в том, что для каждого варианта определяется категория или класс , которому он принадлежит. В качестве примера можно привести оценку кредитоспособности потенциального заемщика: назначаемые классы здесь могут быть "кредитоспособен" и "некредитоспособен". Необходимо отметить, что для решения задачи необходимо, чтобы множество классов было известно заранее и было бы конечным и счетным.

Задача регрессии во многом схожа с задачей классификации, но в ходе ее решения производится поиск шаблонов для определения числового значения. Иными словами, предсказываемый параметр здесь, как правило, число из непрерывного диапазона.

Отдельно выделяется задача прогнозирования новых значений на основании имеющихся значений числовой последовательности (или нескольких последовательностей, между значениями в которых наблюдается корреляция). При этом могут учитываться имеющиеся тенденции (тренды), сезонность, другие факторы. Классическим примером является прогнозирование цен акций на бирже.

Тут требуется сделать небольшое отступление. По способу решения задачи интеллектуального анализа можно разделить на два класса: обучение с учителем (от англ. supervisedlearning) и обучение без учителя (от англ. unsupervisedlearning). В первом случае требуется обучающий набор данных, на котором создается и обучается модель интеллектуального анализа данных. Готовая модель тестируется и впоследствии используется для предсказания значений в новых наборах данных. Иногда в этом же случае говорят об управляемых алгоритмах интеллектуального анализа. Задачи классификации и регрессии относятся как раз к этому типу.

Во втором случае целью является выявление закономерностей имеющихся в существующем наборе данных. При этом обучающая выборка не требуется. В качестве примера можно привести задачу анализа потребительской корзины, когда в ходе исследования выявляются товары, чаще всего покупаемые вместе. К этому же классу относится задача кластеризации.

Также можно говорить о классификации задач интеллектуального анализа данных по назначению, в соответствии с которой,они делятся на описательные (descriptive) и предсказательные (predictive). Цель решения описательных задач - лучше понять исследуемые данные, выявить имеющиеся в них закономерности, даже если в других наборах данных они встречаться не будут. Для предсказательных задач характерно то, что в ходе их решения на основании набора данных с известными результатами строится модель для предсказания новых значений.

Но вернемся к перечислению задач интеллектуального анализа данных.

Задача кластеризации - заключается в делении множества объектов на группы (кластеры) схожих по параметрам. При этом, в отличие от классификации, число кластеров и их характеристики могут быть заранее неизвестны и определяться в ходе построения кластеров исходя из степени близости объединяемых объектов по совокупности параметров.

Другое название этой задачи - сегментация . Например, интернет-магазин может быть заинтересован в проведении подобного анализа базы своих клиентов, для того, чтобы потом сформировать специальные предложения для выделенных групп, учитывая их особенности.

Кластеризация относится к задачам обучения без учителя (или "неуправляемым" задачам).

Задача определения взаимосвязей , также называемая задачей поиска ассоциативных правил , заключается в определении часто встречающихся наборов объектов среди множества подобных наборов. Классическим примером является анализ потребительской корзины, который позволяет определить наборы товаров, чаще всего встречающиеся в одном заказе (или в одном чеке). Эта информация может потом использоваться при размещении товаров в торговом зале или при формировании специальных предложений для группы связанных товаров.

Данная задача также относится к классу "обучение без учителя".

Анализ последовательностей или сиквенциальный анализ одними авторами рассматривается как вариант предыдущей задачи, другими - выделяется отдельно. Целью, в данном случае, является обнаружение закономерностей в последовательностях событий. Подобная информация позволяет, например, предупредить сбой в работе информационной системы, получив сигнал о наступлении события, часто предшествующего сбою подобного типа. Другой пример применения - анализ последовательности переходов по страницам пользователей web-сайтов.

Анализ отклонений позволяет отыскать среди